Korrelation

Für zwei metrische Variablen lässt sich der Zusammenhang über die sog. Kovarianz berechnen.

Wenn die Variablen mit $x$ und $y$ bezeichnet werden, ergibt sich die Kovarianz aus der Formel:

$$ s_{x, y}^2 = \frac{1}{N-1}\sum_{i=1}^{N}(x_i-\bar{x})(y_i-\bar{y}) , $$

wobei $\bar{x}$ und $\bar{y}$ die entsprechenden Mittelwerte darstellen und $N$ die Größe der Stichprobe (die Anzahl an Elementen in der Datenreihe von $x$ oder $y$).

Ein positiver Wert der Kovarianz drückt aus, dass wenn die Werte der einen Variablen steigen, dies auch für die andere Variable gilt. Eine negative Kovarianz bedeutet hingegen, dass wenn die Werte der einen Variablen steigen, die Werte der anderen Variablen sinken.

Auch wenn die Kovarianz mit der Stärke des Zusammenhangs steigt, ist es immer noch relativ schwierig, aus dem errechneten Wert herauszufinden, wie stark der Zusammenhang zwischen den Variablen ist.

Zusätzlich zur Kovarianz, ist der Korrelationskoeffizient eine wichtige Kennzahl. Der Korrelationskoeffizient $\rho_{x, y}$ misst für zwei metrische Variablen $x$ und $y$ die Stärke des linearen Zusammenhangs. Man sagt auch, dass der Korrelationskoeffizient die standardisierte Kovanrianz darstellt.

Der Korrelationskoeffizient ist definiert als: $$ \rho_{x, y} = \frac{s_{x, y}^2}{s_xs_y} = \frac{\sum_{i=1}^{N}(x_i-\bar{x})(y_i-\bar{y})}{\sqrt{\sum_{i=1}^{N}(x_i-\bar{x})^2\sum_{i=1}^{N}(y_i-\bar{y})^2}} . $$

In dieser Formel erkennt man im Zähler die Kovarianz und im Nenner die einzelnen Varianzen (die entsprechenden $N-1$-Werte kürzen sich bei Austellen der Formel weg).

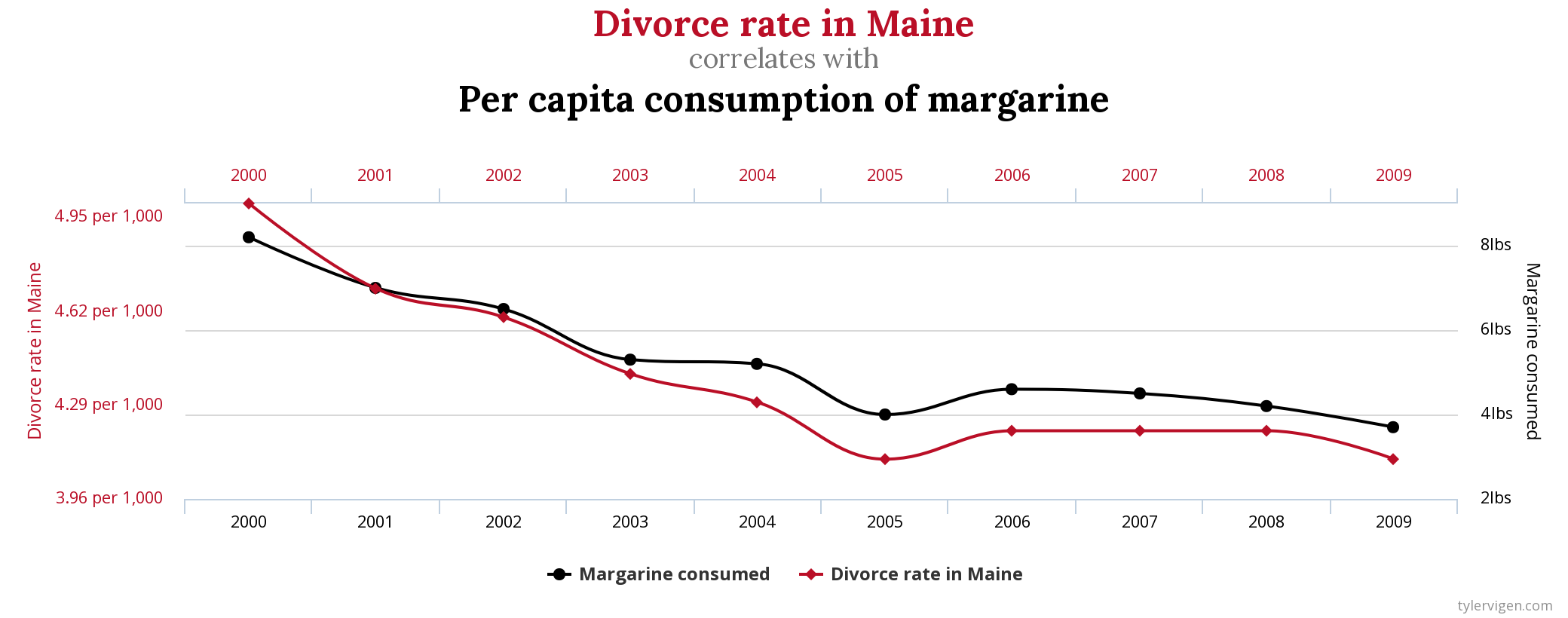

Der Koeffizient kann Werte zwischen $-1$ (negativer Zusammenhang) und $1$ (positiver Zusammenhang) annehmen. Nachfolgend ein Beispiel von zufällig generierten Variablen mit verschiedenen Korrelationskoeffizienten: